การใช้งาน Chinda LLM 4B กับ OpenWebUI - คู่มือผู้ใช้ฉบับสมบูรณ์

🎯 บทนำ

Chinda LLM 4B คือแบบจำลองภาษาไทยโอเพนซอร์สที่พัฒนาโดยทีมงาน ไอแอพพ์เทคโนโลยี สามารถคิดและตอบสนองเป็นภาษาไทยได้อย่างแม่นยำสูง โดยใช้สถาปัตยกรรม Qwen3-4B ล่าสุด

OpenWebUI คืออินเทอร์เฟซเว็บที่สวยงามและใช้งานง่ายสำหรับ Ollama ที่มอบประสบการณ์คล้าย ChatGPT สำหรับแบบจำลอง AI ในเครื่องของคุณ มีอินเทอร์เฟซแชทที่ใช้งานง่ายพร้อมคุณสมบัติต่างๆ เช่น ประวัติการสนทนา การจัดการแบบจำลอง และการตั้งค่าที่ปรับแต่งได้

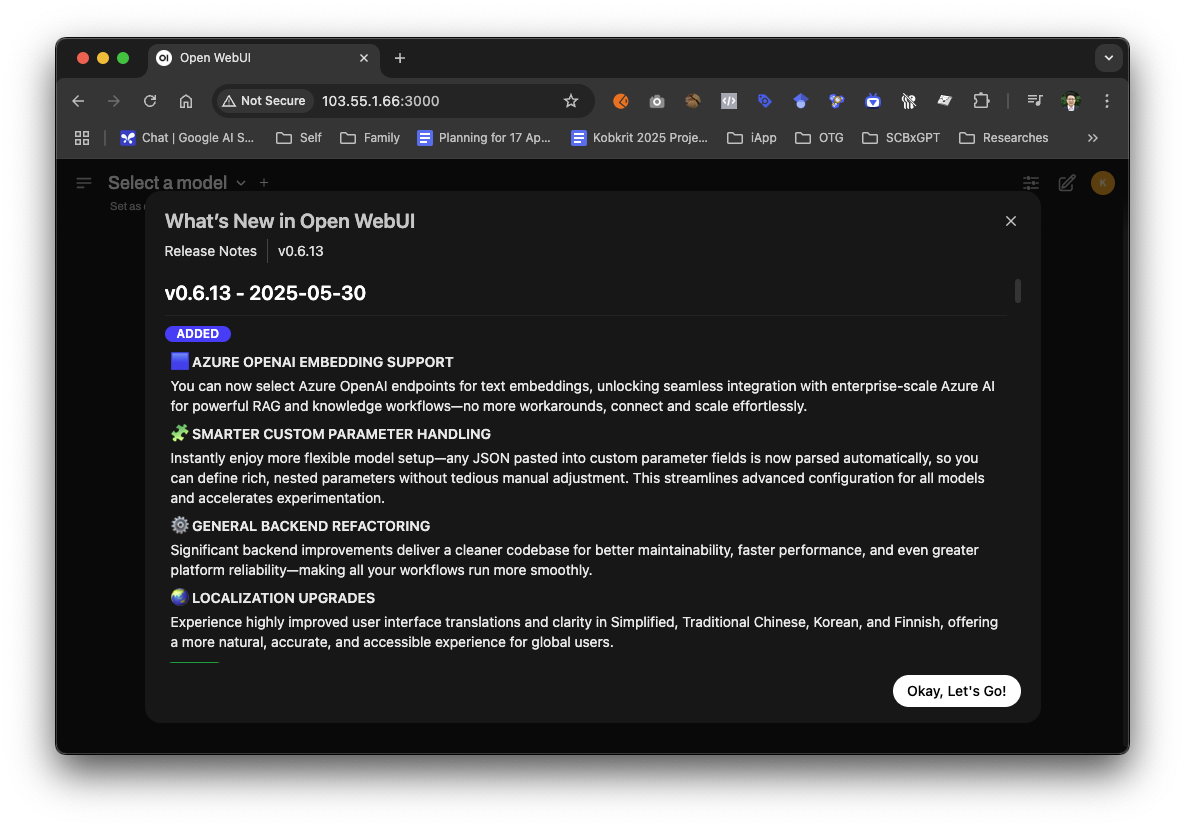

เวอร์ชันล่าสุดของ OpenWebUI (v0.6.13) มีคุณสมบัติใหม่ที่น่าตื่นเต้น เช่น การรองรับ Azure OpenAI embedding, การจัดการพารามิเตอร์แบบกำหนดเองที่ชาญฉลาดขึ้น, การปรับโครงสร้างแบ็กเอนด์ทั่วไป และการแปลภาษาที่ดีขึ้นสำหรับหลายภาษา

🚀 ขั้นตอนที่ 1: การติดตั้ง Docker

ติดตั้ง Docker

หากคุณยังไม่ได้ติดตั้ง Docker:

- Windows/Mac: ดาวน์โหลดจาก https://www.docker.com/products/docker-desktop

- Linux: ทำตามคู่มือการติดตั้ง Docker ของดิสทริบิวชันของคุณ

การตั้งค่าการรองรับ GPU (ไม่บังคับ แต่แนะนำ)

สำหรับ NVIDIA GPUs:

ติดตั้ง NVIDIA Container Toolkit เพื่อเปิดใช้งานการเร่งความเร็วด้วย GPU:

Ubuntu/Debian:

# เพิ่มที่เก็บแพ็คเกจ NVIDIA

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add -

curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

# ติดตั้ง nvidia-container-toolkit

sudo apt-get update && sudo apt-get install -y nvidia-container-toolkit

sudo systemctl restart docker

สำหรับดิสทริบิวชัน Linux อื่นๆ, macOS หรือ Windows: ทำตาม คู่มือการติดตั้ง NVIDIA Container Toolkit

📱 ขั้นตอนที่ 2: การเรียกใช้ OpenWebUI กับ Ollama ที่รวมเข้าด้วยกัน

วิธีที่ 1: OpenWebUI กับ Ollama ในตัว (แนะนำ)

วิธีนี้จะเรียกใช้ทั้ง OpenWebUI และ Ollama ในการตั้งค่าคอนเทนเนอร์เดียว:

สำหรับระบบที่ไม่มี GPU:

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

สำหรับระบบที่มี NVIDIA GPU:

docker run -d -p 3000:8080 --gpus all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

วิธีที่ 2: การใช้ Docker Compose (��ขั้นสูง)

สร้างไฟล์ docker-compose.yml:

version: '3.8'

services:

open-webui:

image: ghcr.io/open-webui/open-webui:ollama

container_name: open-webui

ports:

- "3000:8080"

volumes:

- ollama:/root/.ollama

- open-webui:/app/backend/data

restart: always

# ยกเลิกการแสดงความคิดเห็นในบรรทัดต่อไปนี้สำหรับการรองรับ GPU

# deploy:

# resources:

# reservations:

# devices:

# - driver: nvidia

# count: all

# capabilities: [gpu]

volumes:

ollama:

open-webui:

เรียกใช้ด้วย:

docker-compose up -d

เข้าถึง OpenWebUI

- เปิดเว็บเบราว์เซอร์ของคุณ

- ไปที่

http://localhost:3000 - คุณควรจะเห็นหน้าจอต้อนรับของ OpenWebUI

🔍 ขั้นตอนที่ 3: ดาวน์โหลดแบบจำลอง Chinda LLM 4B

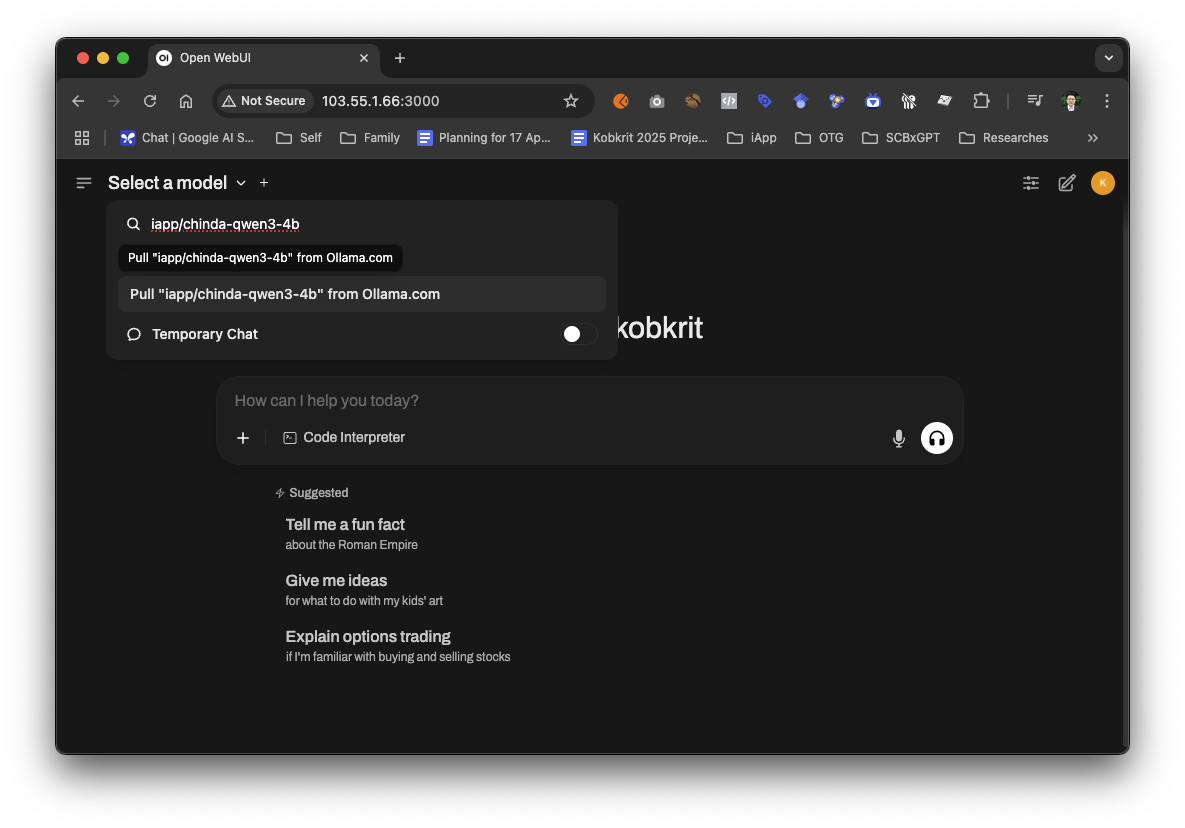

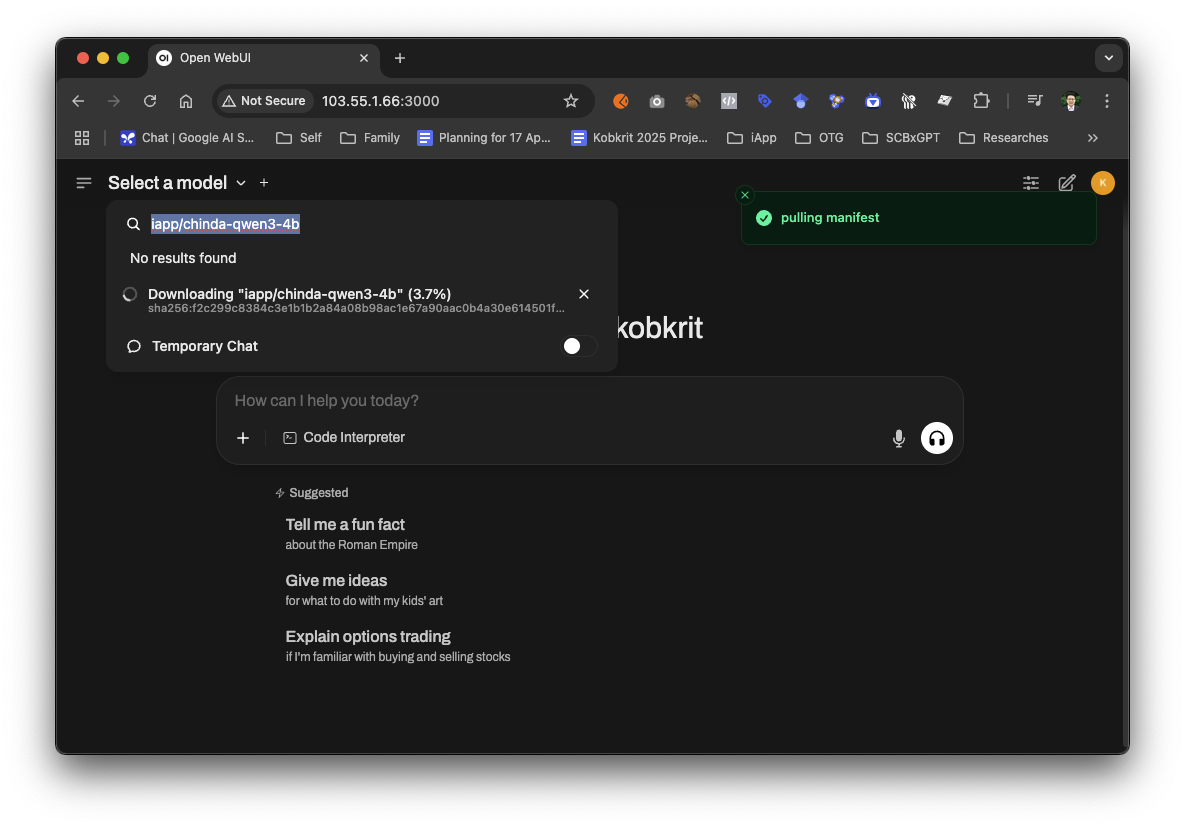

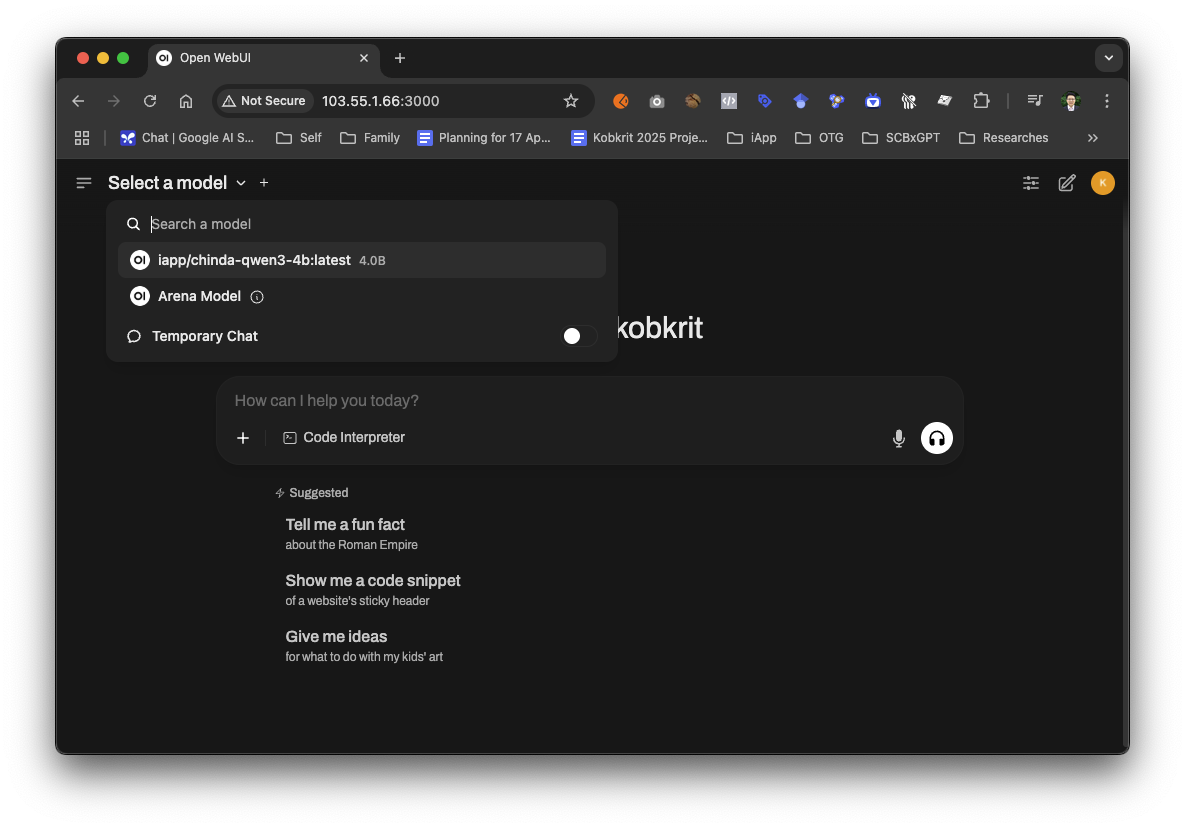

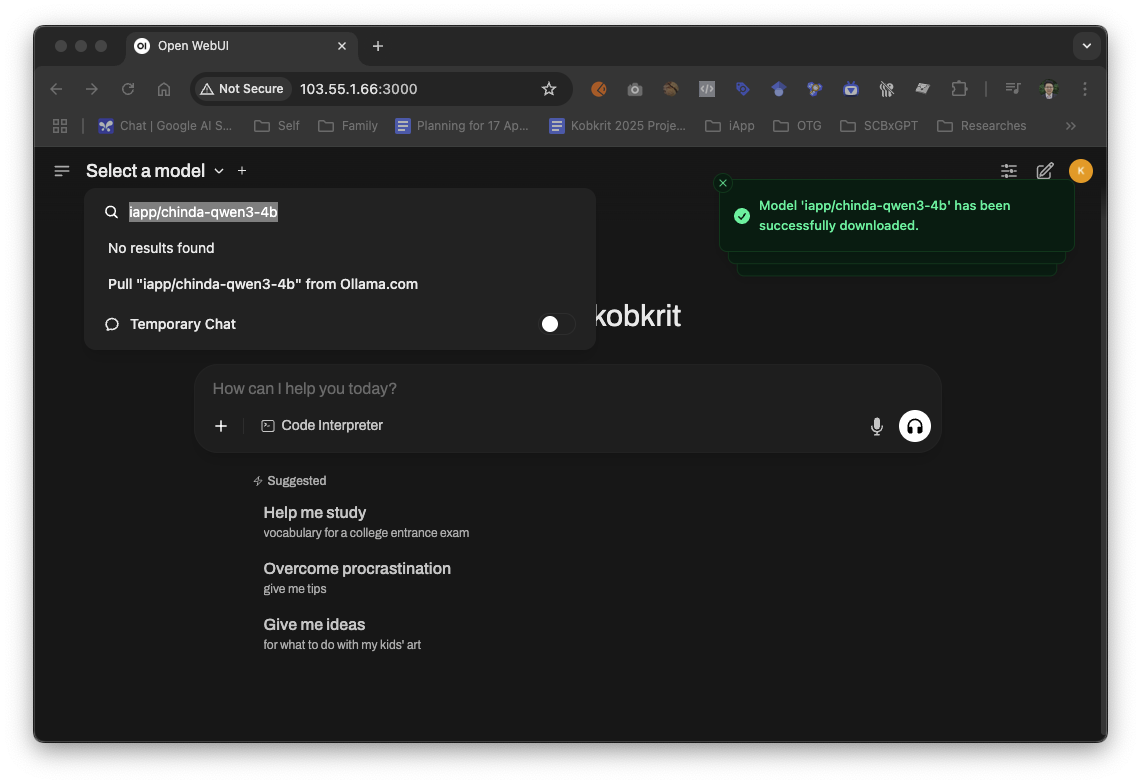

การใช้อินเทอร์เฟซ OpenWebUI (แนะนำ)

เมื่อ OpenWebUI ทำงานอยู่ คุณสามารถดาวน์โหลดแบบจำลอง Chinda LLM 4B ได้โดยตรงผ่านทางอินเทอร์เฟซเว็บ:

- เปิดเบราว์เซอร์ของคุณและไปที่

http://localhost:3000 - ทำการตั้งค่าเริ่มต้นให้เสร็จสมบูรณ์ (สร้างบัญชี)

- ค้นหาแบบจำลองโดยพิมพ์

iapp/chinda-qwen3-4bในช่องค้นหาแบบจำลอง

- คลิก ดึง "iapp/chinda-qwen3-4b" จาก Ollama.com

- รอให้การดาวน์โหลดเสร็จสมบูรณ์ (ประมาณ 2.5GB)

- คุณจะเห�็นการแจ้งเตือนความสำเร็จเมื่อดาวน์โหลดแบบจำลองเสร็จสิ้น

การใช้ Docker Exec (วิธีอื่น)

คุณยังสามารถดาวน์โหลดแบบจำลองโดยใช้ Docker exec:

# ดาวน์โหลดแบบจำลอง Chinda LLM 4B

docker exec -it open-webui ollama pull iapp/chinda-qwen3-4b

# ตรวจสอบว่าดาวน์โหลดแบบจำลองเสร็จแล้ว

docker exec -it open-webui ollama list

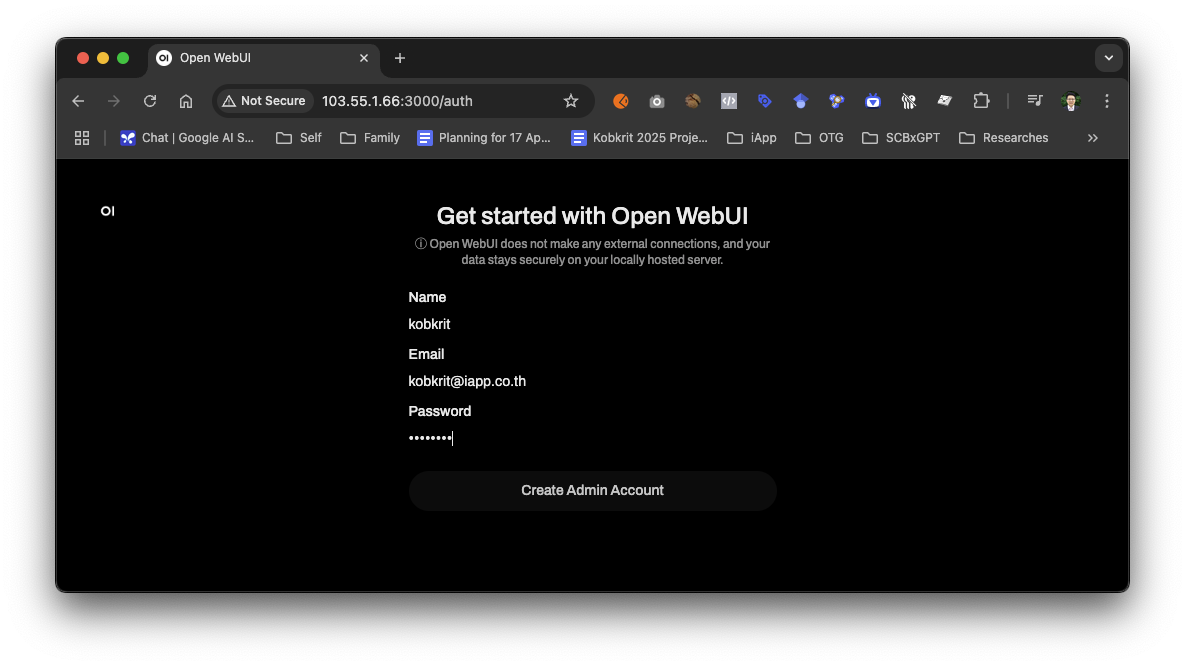

🔍 ขั้นตอนที่ 4: การตั้งค่าเริ่มต้น

สร้างบัญชีของคุณ

- ในการเข้าชมครั้งแรก คุณจะเห็นแบบฟอร์ม ลงทะเบียน

- ป้อนอีเมลและรหัสผ่านที่คุณต้องการ

- คลิก สร้างบัญชี

- คุณจะเข้าสู่ระบบโดยอัตโนมัติ

หมายเหตุ: นี่เป็นบัญชีเฉพาะเครื่องของคุณเท่านั้น - ไม่มีข้อมูลใดถูกส่งไปยังเซิร์ฟเวอร์ภายนอก

⚙️ ขั้นตอนที่ 5: การใช้ Chinda LLM 4B

เลือกแบบจำลอง

- ในอินเทอร์เฟซแชท ให้มองหาเมนูแบบเลื่อนลง แบบจำลอง ที่ด้านบน

- เลือก

chinda-qwen3-4b:latestจากรายการ - หากคุณไม่เห็น ให้ตรวจสอบว่าคุณได้ดาวน์โหลดแบบจำลองโดยใช้ขั้นตอนข้างต้นแล้ว

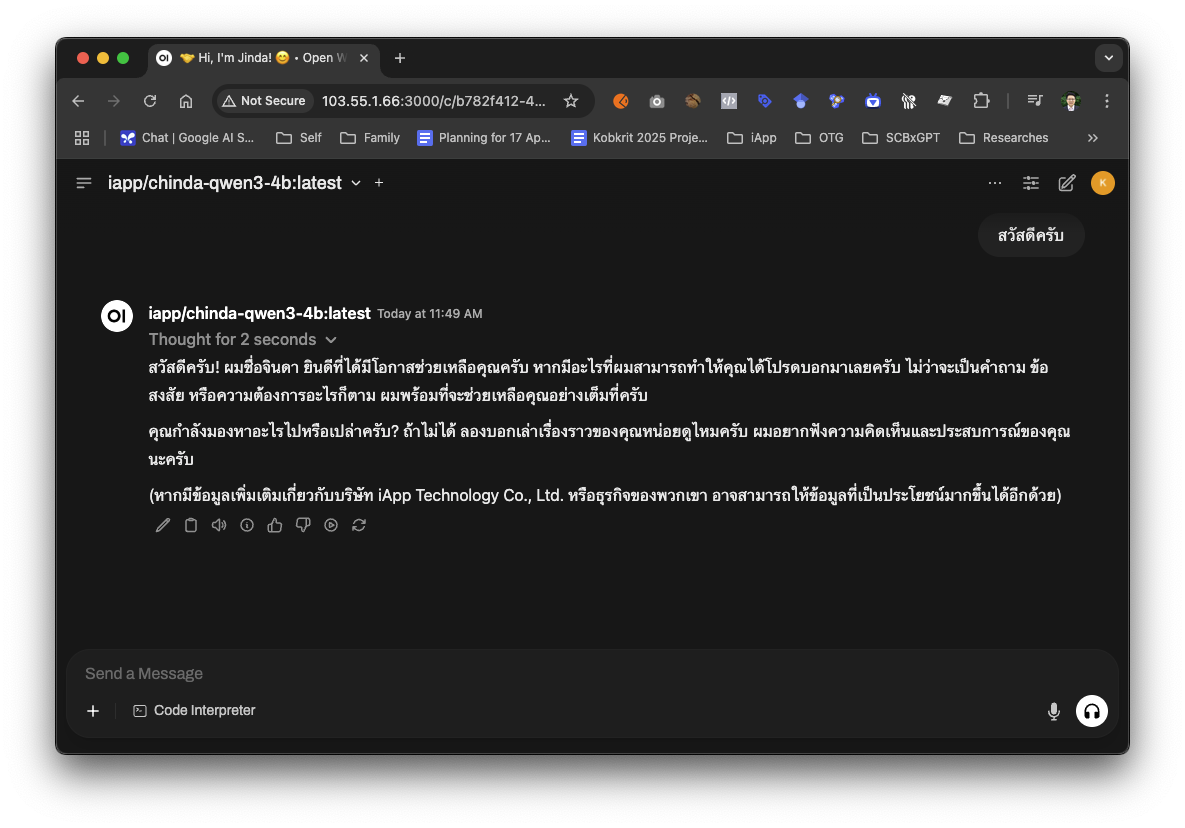

เริ่มต้นการสนทนาครั้งแรกของคุณ

- พิมพ์ข้อความของคุณเป็นภาษาไทยในช่องแชท

- กด Enter หรือคลิกปุ่มส่ง

- Chinda LLM จะตอบกลับเป็นภาษาไทย

ตัวอย่างการสนทนา:

อย่างที่คุณเห็นในภาพหน้าจอด้านบน Chinda LLM ตอบกลับเป็นภาษาไทยอย่างเป็นธรรมชาติและแนะนำตัวเองว่าเป็นผู้ช่วย AI ที่พัฒนาโดย บริษัท ไอแอพพ์เทคโนโลยี จำกัด แบบจำลองแสดงให้เห็นถึงความสามารถในการทำความเข้าใจบริบทและให้คำตอบ��ที่รอบคอบเป็นภาษาไทย

คำถามทางคณิตศาสตร์:

คุณ: ช่วยแก้สมการ 3x + 7 = 22 ให้หน่อย

Chinda: ผมจะช่วยแก้สมการ 3x + 7 = 22 ให้คุณครับ

ขั้นตอนการแก้:

1) 3x + 7 = 22

2) 3x = 22 - 7

3) 3x = 15

4) x = 15 ÷ 3

5) x = 5

ดังนั้น x = 5 ครับ

การเขียนเอกสาร:

คุณ: ช่วยเขียนอีเมลขอบคุณลูกค้าให้หน่อย

Chinda: ผมจะช่วยเขียนอีเมลขอบคุณลูกค้าให้คุณครับ

เรื่อง: ขอบพระคุณสำหรับการใช้บริการ

เรียน คุณลูกค้าที่เคารพ,

ทางบริษัทฯ ขอขอบ�พระคุณอย่างสูงสำหรับการให้ความไว้วางใจและใช้บริการของเรา...

🎨 ขั้นตอนที่ 6: คุณสมบัติขั้นสูง

การจัดการการสนทนา

สร้างการสนทนาใหม่:

- คลิกปุ่ม + เพื่อเริ่มการสนทนาใหม่

- การสนทนาแต่ละครั้งจะถูกบันทึกแยกกัน

- คุณสามารถสลับระหว่างการสนทนาได้ตลอดเวลา

เปลี่ยนชื่อการสนทนา:

- คลิกที่ชื่อหัวข้อการสนทนา

- ป้อนชื่อใหม่เพื่อจัดระเบียบการแชทของคุณ

ส่งออกการสนทนา:

- คลิกที่การตั้งค่าการสนทนา (สามจุด)

- เลือก ส่งออก เพื่อบันทึกเป็น JSON หรือ Markdown

ปรับแต่งการตั้งค่าแบบจำลอง

เข้าถึงการตั้งค่าแบบจำลอง:

- คลิกไอคอน การตั้งค่า ถัดจากชื่อแบบจำลอง

- ปรับพารามิเตอร์ต่างๆ เช่น:

- อุณหภูมิ (0.1-1.0): ควบคุมความคิดสร้างสรรค์

- Top P (0.1-1.0): ควบคุมความหลากหลายของคำตอบ

- Top K (1-100): จำกัดตัวเลือกคำศัพท์

- โทเค็นสูงสุด: ความยาวของคำตอบสูงสุด

การตั้งค่าที่แนะนำสำหรับ Chinda LLM:

- อุณหภูมิ: 0.7 (ความคิดสร้างสรรค์ที่สมดุล)

- Top P: 0.9 (ความหลากหลายที่ดี)

- Top K: 40 (คำตอบที่เน้น)

คำแนะนำระบบ

คุณสามารถตั้งค่าคำแนะนำระบบแบบกำหนดเองเพื่อปรับเปลี่ยนพฤติกรรมของ Chinda:

ตัวอย่างคำแนะนำระบบ:

สำหรับการเขียนอย่างมืออาชีพ:

คุณเป็นผู้ช่วยเขียนเอกสารมืออาชีพ ตอบด้วยภาษาไทยที่เป็นทางการและสุภาพ

สำหรับเนื้อหาทางการศึกษา:

คุณเป็นครูสอนภาษาไทย อธิบายให้เข้าใจง่าย ใช้ตัวอย่างประกอบ

สำหรับการเขียนเชิงสร้างสรรค์:

คุณเป็นนักเขียนที่มีจินตนาการสูง สร้างเนื้อหาที่น่าสนใจและสร้างสรรค์

📊 ขั้นตอนที่ 7: การจัดการแบบจำลอง

ดูแบบจำลองที่มีอยู่

- ไปที่ การตั้งค่า → แบบจำลอง

- ดูแบบจำลองที่ดาวน์โหลดทั้งหมด

- ตรวจสอบขนาดและข้อมูลของแบบจำลอง

ดาวน์โหลดแบบจำลองใหม่

การใช้คอนเทนเนอร์:

# ดาวน์โหลดแบบจำลองใหม่โดยใช้ docker exec

docker exec -it open-webui ollama pull <model-name>

หรือใช้อินเทอร์เฟซ OpenWebUI: การตั้งค่า → แบบจำลอง → ดึงแบบจำลองจาก Ollama.com

ลบแบบจำลอง

# ลบแบบจำลองโดยใช้ docker exec

docker exec -it open-webui ollama rm <model-name>

🔧 ขั้นตอนที่ 8: การแก้ปัญหา

ปัญหาและวิธีแก้ไขทั่วไป

ปัญหา: ไม่เห็นแบบจำลอง Chinda

อาการ: แบบจำลองไม่ปรากฏในเมนูแบบเลื่อนลง วิธีแก้ไข:

- ตรวจสอบว่าคอนเทนเนอร์กำลังทำงานอยู่:

docker ps - ตรวจสอบว่าดาวน์โหลดแบบจำลองแล้ว:

docker exec -it open-webui ollama list - ดาวน์โหลดแบบจำลองหากจำเป็น:

docker exec -it open-webui ollama pull iapp/chinda-qwen3-4b - รี�เฟรชหน้า OpenWebUI

ปัญหา: "ข้อผิดพลาดในการเชื่อมต่อ" หรือคอนเทนเนอร์ไม่เริ่มทำงาน

อาการ: ไม่สามารถเข้าถึง OpenWebUI หรือคอนเทนเนอร์ไม่สามารถเริ่มทำงานได้ วิธีแก้ไข:

- ตรวจสอบว่า Docker กำลังทำงานอยู่:

docker version - ตรวจสอบสถานะคอนเทนเนอร์:

docker ps -a - ตรวจสอบบันทึกของคอนเทนเนอร์:

docker logs open-webui - เริ่มคอนเทนเนอร์ใหม่:

docker restart open-webui

ปัญหา: การตอบสนองช้า

วิธีแก้ไข:

- ปิดแอปพลิเคชันที่ไม่จำเป็น

- ลดโทเค็นสูงสุดในการตั้งค่าแบบจำลอง

- ลดค่าอุณหภูมิและ top_k

- ตรวจสอบให้แน่ใจว่ามี RAM เพียงพอ (แนะนำอย่างน้อย 8GB)

ปัญหา: GPU ไม่ทำงาน

อาการ: ประสิทธิภาพต่ำแม้จะมี GPU วิธีแก้ไข:

- ตรวจสอบไดรเวอร์ NVIDIA:

nvidia-smi - ตรวจสอบ NVIDIA Container Toolkit:

docker run --rm --gpus all nvidia/cuda:11.0-base nvidia-smi - เริ่มคอนเทนเนอร์ใหม่พร้อมการรองรับ GPU:

# หยุดคอนเทนเนอร์ที่มีอยู่

docker stop open-webui

docker rm open-webui

# เรียกใช้พร้อมการรองรับ GPU

docker run -d -p 3000:8080 --gpus all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

การเพิ่มประสิทธิภาพ

- ใช้ที่เก็บข้อมูล SSD เพื่อการโหลดแบบจำลองที่ดีขึ้น

- จัดสรร RAM ให้เพียงพอ (อย่างน้อย 8GB)

- ปิดแอปพลิเคชันพื้นหลัง

- ใช้การตั้งค่าความแม่นยำที่ต่ำกว่า หากหน่วยความจำมีจำกัด

🎯 กรณีการใช้งานที่เหมาะสม

✅ สิ่งที่ Chinda LLM 4B ทำได้ดีใน OpenWebUI

- การสนทนาแบบโต้ตอบ - ประสบการณ์การแชทที่เป็นธรรมชาติพร้อมประวัติการสนทนา

- การร่างเอกสาร - เขียนและแก้ไขเอกสารได้อย่างง่ายดาย

- เนื้อหาทางการศึกษา - เรียนรู้ด้วยการอ้างอิงการสนทนาที่บันทึกไว้

- การเขียนเชิงสร้างสรรค์ - พัฒนาเรื่องราวและเนื้อหาด้วยการแก้ไขหลายครั้ง

- ความช่วยเหลือด้านการเขียนโปรแกรม - การสร้างโค้ดพร้อมไฮไลต์ไวยากรณ์

- การแปลภาษา - การแปลภาษาไทย-อังกฤษอย่างรวดเร็ว

- ผู้ช่วยวิจัย - จัดระเบียบข้อมูลในหลายๆ การสนทนา

🌟 ข้อดีเฉพาะของ OpenWebUI

- อินเทอร์เฟซที่สวยงาม - การออกแบบที่สะอาดและทันสมัยเหมือน ChatGPT

- ประวัติการสนทนา - การแชททั้งหมดจะถูกบันทึกโดยอัตโนมัติ

- รองรับแบบจำลองหลายแบบ - สลับระหว่างแบบจำลองต่างๆ ได้อย่างง่ายดาย

- ตัวเลือกการส่งออก - บันทึกการสนทนาในรูปแบบต่างๆ

- การตั้งค่าที่ปรับแต่งได้ - ปรับแต่งพฤติกรรมของแบบจำ�ลองต่อการสนทนา

- ไม่ต้องใช้ internet - ความเป็นส่วนตัวอย่างสมบูรณ์ด้วยการประมวลผลในเครื่อง

❌ ข้อจำกัดที่ควรทราบ

อย่าถามข้อเท็จจริงโดยไม่มีบริบท เช่น:

- เหตุการณ์ข่าวล่าสุด (การตัดการฝึกอบรมแบบจำลองใช้ได้)

- ข้อมูลสถิติเฉพาะโดยไม่มีแหล่งที่มา

- ข้อมูลแบบเรียลไทม์

- ข้อมูลเกี่ยวกับบุคคลเฉพาะหรือเหตุการณ์ปัจจุบัน

เนื่องจาก Chinda LLM 4B เป็นแบบจำลองพารามิเตอร์ 4B อาจสร้างข้อมูลที่ไม่ถูกต้อง (ภาพหลอน) เมื่อถูกถามเกี่ยวกับข้อเท็จจริงเฉพาะ

🚀 ข้อมูลจำเพาะของแบบจำลอง

- ขนาด: 2.5GB (แบบลดขนาด)

- หน้าต่างบริบท: 40K โทเค็น

- สถาปัตยกรรม: ใช้ Qwen3-4B เป็นพื้นฐาน ปรับให้เหมาะสมสำหรับภาษาไทย

- ประสิทธิภาพ: การอนุมานที่รวดเร็วบนฮาร์ดแวร์สำหรับผู้บริโภค

- ความต้องการหน่วยความจำ: RAM อย่างน้อย 4GB แนะนำ 8GB ขึ้นไป

- อินเทอร์เฟซ: อินเทอร์เฟซแชทบนเว็บที่ทันสมัย

🔮 สิ่งที่จะเกิดขึ้นต่อไป

ทีมงาน ไอแอพพ์เทคโนโลยี กำลังพัฒนาแบบจำลองใหม่ที่มีขนาดใหญ่ขึ้น ซึ่งจะสามารถตอบคำถามข้อเท็จจริงได้อย่างแม่นยำยิ่งขึ้น คาดว่าจะเปิดตัวในเร็วๆ นี้และจะสามารถใช้งานร่วมกับ OpenWebUI ได้

📚 แหล่งข้อมูลเพิ่มเติม

คำสั่งตั้งค่าด่วน

ไม่มี GPU:

# 1. เรียกใช้ OpenWebUI พร้อม Ollama ในตัว

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

# 2. เปิดเบราว์เซอร์ไปที่ http://localhost:3000

# 3. ดาวน์โหลดแบบจำลอง Chinda LLM (ผ่านทางเว็บอินเทอร์เฟซหรือคำสั่ง)

docker exec -it open-webui ollama pull iapp/chinda-qwen3-4b

มี GPU:

# 1. เรียกใช้ OpenWebUI พร้อมการรองรับ GPU

docker run -d -p 3000:8080 --gpus all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

# 2. เปิดเบราว์เซอร์ไปที่ http://localhost:3000

# 3. ดาวน์โหลดแบบจำลอง Chinda LLM

docker exec -it open-webui ollama pull iapp/chinda-qwen3-4b

ทางลัดแป้นพิมพ์ที่มีประโยชน์

- Ctrl/Cmd + Enter: ส่งข้อความ

- Ctrl/Cmd + N: การสนทนาใหม่

- Ctrl/Cmd + K: โฟกัสการค้นหา

- Esc: ยกเลิกการสร้างปัจจุบัน

คำสั่งการจัดการ Docker

# ดูสถานะคอนเทนเนอร์

docker ps

# หยุด OpenWebUI

docker stop open-webui

# เริ่ม OpenWebUI

docker start open-webui

# เริ่ม OpenWebUI ใหม่

docker restart open-webui

# ดูบันทึก

docker logs open-webui

# เข้าถึงเชลล์คอนเทนเนอร์

docker exec -it open-webui bash

# ตรวจสอบแบบจำลอง Ollama ภายในคอนเทนเนอร์

docker exec -it open-webui ollama list

# อัปเดต OpenWebUI

docker pull ghcr.io/open-webui/open-webui:ollama

docker stop open-webui

docker rm open-webui

# จากนั้นเรียกใช้คำสั่งการติดตั้งอีกครั้ง

# สำรองข้อมูลโวลุ่ม (สำคัญ!)

docker run --rm -v ollama:/source -v $(pwd):/backup alpine tar czf /backup/ollama-backup.tar.gz -C /source .

docker run --rm -v open-webui:/source -v $(pwd):/backup alpine tar czf /backup/openwebui-backup.tar.gz -C /source .

ลิงก์และแหล่งข้อมูล

- 🌐 เดโม: https://chindax.iapp.co.th (เลือก ChindaLLM 4b)

- 📦 ดาวน์โหลดแบบจำลอง: https://huggingface.co/iapp/chinda-qwen3-4b

- 🐋 Ollama: https://ollama.com/iapp/chinda-qwen3-4b

- 🌐 OpenWebUI: https://github.com/open-webui/open-webui

- 🏠 หน้าหลัก: https://iapp.co.th/products/chinda-opensource-llm

- 📄 ใบอนุญาต: Apache 2.0 (สามารถใช้ได้ทั้งเชิงพาณิชย์และส่วนบุคคล)

🎉 สรุป

Chinda LLM 4B กับ OpenWebUI มอบการผสมผสานที่ลงตัวระหว่างความสามารถของ AI ภาษาไทยที่ทรงพลังกับอินเทอร์เฟซที่สวยงามและใช้งานง่าย การตั้งค่านี้มอบให้คุณ:

ประโยชน์ที่สำคัญ:

- 🎨 อินเทอร์เฟซที่สวยงาม - UI เว็บที่ทันสมัยคล้ายกับ ChatGPT

- 💾 ประวัติการสนทนา - ไม่เคยสูญเสียการแชทที่สำคัญของคุณ

- 🔒 ความเป็นส่วนตัวอย่างสมบูรณ์ - ทุกอย่างทำงานในเครื่องของคุณ

- 🚀 ใช้งานง่าย - ไม่จำเป็นต้องมีความรู้เกี่ยวกับบรรทัดคำสั่ง

- 🎛️ ปรับแต่งได้ - ปรับการตั้งค่าสำหรับกรณีการใช้งานต่างๆ

- 📱 รองรับหลายแพลตฟอร์ม - ทำงานบนอุปกรณ์ใดๆ ที่มีเว็บเบราว์เซอร์

เหมาะสำหรับ:

- นักเรียนและนักวิจัย ที่ต้องการประวัติการสนทนาที่เป็นระเบียบ

- นักเขียนและผู้สร้างเนื้อหา ที่ต้องการพัฒนาความคิด

- ผู้เชี่ยวชาญทางธุรกิจ ที่ต้องการความช่วยเหลือในการร่างเอกสาร

- นักพัฒนา ที่ต้องการอินเทอร์เฟซที่ใช้งานง่ายสำหรับการผสานรวม AI

- ทุกคน ที่ชอบอินเทอร์เฟซเว็บมากกว่าเครื่องมือบรรทัดคำสั่ง

เริ่มใช้ Chinda LLM 4B กับ OpenWebUI วันนี้และสัมผัสอนาคตของ AI ภาษาไทยด้วยความสะดวกสบายของอินเทอร์เฟซเว็บที่ทันสมัย!

สร้างด้วย ❤️ โดยทีมงาน ไอแอพพ์เทคโนโลยี - เพื่อการพัฒนา AI ภาษาไทย