การใช้งาน Chinda LLM 4B กับ n8n - คู่มือการทำงานอัตโนมัติแบบครบวงจร

🎯 บทนำ

Chinda LLM 4B คือแบบจำลองภาษาไทยแบบโอเพนซอร์สที่พัฒนาโดยทีมงาน ไอแอพพ์เทคโนโลยี สามารถคิดและตอบสนองเป็นภาษาไทยได้อย่างแม่นยำสูง โดยใช้สถาปัตยกรรม Qwen3-4B ล่าสุด

n8n คือเครื่องมือการทำงานอัตโนมัติที่ทรงพลัง ช่วยให้คุณเชื่อมต่อบริการต่างๆ และทำงานอัตโนมัติได้โดยไม่ต้องเขียนโค้ด ด้วยการผสาน Chinda LLM 4B เข้ากับ n8n คุณสามารถสร้างเวิร์กโฟลว์ที่ใช้พลังของ AI ที่ซับซ้อน ซึ่งประมวลผลข้อมูลภาษาไทยได้โดยอัตโนมัติ

🚀 ขั้นตอนที่ 1: การติดตั้ง n8n

วิธีที่ 1: การใช้ npm (แนะนำสำหรับการพัฒนา)

ติดตั้ง Node.js (หากยังไม่ได้ติดตั้ง)

ดาวน์โหลดและติดตั้ง Node.js จาก https://nodejs.org/

ติดตั้ง n8n แบบทั่วโลก:

npm install n8n -g

เริ่มต้น n8n:

n8n start

วิธีที่ 2: การใช้ Docker (แนะนำสำหรับการใช้งานจริง)

ดึงและเรียกใช้คอนเทนเนอร์ Docker ของ n8n:

docker run -it --rm \

--name n8n \

-p 5678:5678 \

-v ~/.n8n:/home/node/.n8n \

n8nio/n8n

วิธีที่ 3: การใช้ npx (ไม่ต้องติดตั้ง)

npx n8n

ตรวจสอบการติดตั้ง

หลังจากเริ่มต้น n8n แล้ว ให้เปิดเบราว์เซอร์ของคุณและไปที่:

http://localhost:5678

คุณควรจะเห็นอินเทอร์เฟซ n8n พร้อมหน้าจอต้อนรับ

🔍 ขั้นตอนที่ 2: การตั้งค่า Chinda LLM 4B

ตัวเลือก A: การใช้ Ollama Backend (แนะนำ)

ติดตั้ง Ollama:

curl -fsSL https://ollama.com/install.sh | sh

ดาวน์โหลด Chinda LLM 4B:

ollama pull iapp/chinda-qwen3-4b

เริ่มต้นเซิร์ฟเวอร์ API ของ Ollama:

ollama serve

API จะพร้อมใช้งานที่ http://localhost:11434

ตัวเลือก B: การใช้จุดสิ้นสุด API โดยตรง

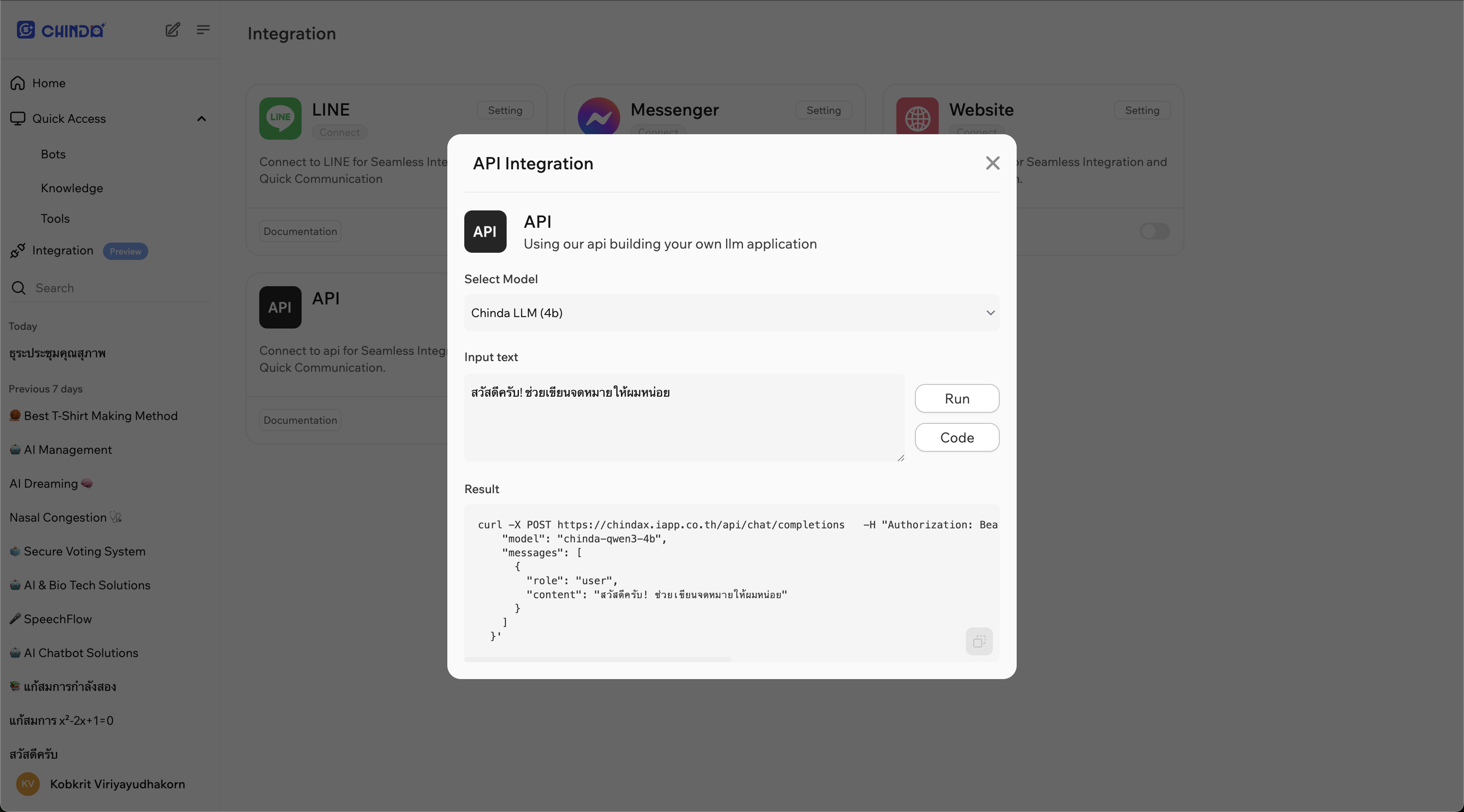

- เปิดแพลตฟอร์ม ChindaX ในเบราว์เซอร์ของคุณ (https://chindax.iapp.co.th)

- ลงทะเบียน / เข้าสู่ระบบ เว็บไซต์ ChindaX

- ไปที่เมนู การผสานรวม ทางด้านซ้าย

- คลิกที่ปุ่ม การตั้งค่า ที่ด้านบนขวาของการผสานรวม API

- คัดลอก URL และ Bearer Token จากบล็อกโค้ด

⚙️ ขั้นตอนที่ 3: การสร้างเวิร์กโฟลว์แรกของคุณ

การตั้งค่าเวิร์กโฟลว์พื้นฐาน

- เปิด n8n ในเบราว์เซอร์ของคุณ (

http://localhost:5678) - คลิก "เวิร์กโฟลว์ใหม่" เพื่อสร้างระบบอัตโนมัติใหม่

- เพิ่มโหนด เพื่อสร้างเวิร์กโฟลว์ AI ของคุณ

ตัวอย่างที่ 1: เวิร์กโฟลว์การประมวลผลข้อความอย่างง่าย

ขั้นตอนที่ 1: เพิ่มตัวกระตุ้นด้วยตนเอง

- คลิกปุ่ม "+" เพื่อเพิ่มโหนด

- ค้นหา "ตัวกระตุ้นด้วยตนเอง" และเลือก

- คลิก "เรียกใช้โหนด" เพื่อทดสอบ

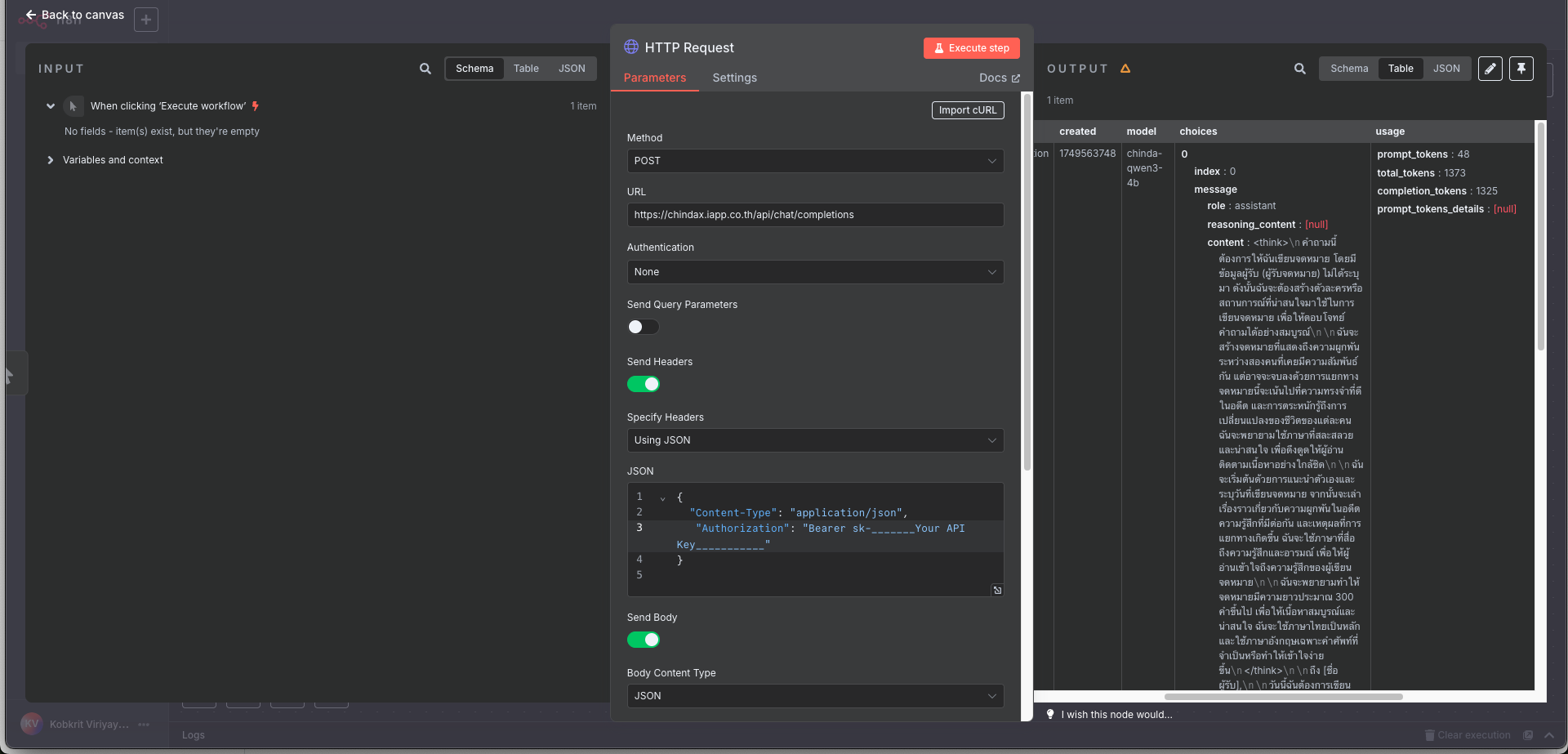

ขั้นตอนที่ 2: เพิ่มโหนด HTTP Request

- เพิ่มโหนดอื่นและค้นหา "HTTP Request"

- กำหนดค่าโหนด HTTP Request:

- วิธีการ: POST

- URL:

http://localhost:11434/api/generateหรือhttps://chindax.iapp.co.th/api/chat/completions(จาก ChindaX) - ส่วนหัว: ถ้าคุณได้รับ API จาก ChindaX อย่าลืมเพิ่มคีย์ "Authorization"

{

"Content-Type": "application/json",

"Authorization": "Bearer sk-********************",

} - เนื้อหา: (สำหรับ Ollama)

{

"model": "iapp/chinda-qwen3-4b",

"prompt": "สวัสดีครับ ช่วยอธิบายเกี่ยวกับปัญญาประดิษฐ์ให้ฟังหน่อย",

"stream": false

} - เนื้อหา: (สำหรับ ChindaX)

{

"model": "chinda-qwen3-4b",

"messages": [

{

"role": "user",

"content": "สวัสดีครับ! ช่วยเขียนจดหมายให้ผมหน่อย"

}

]

}

ขั้นตอนที่ 3: เพิ่มโหนด Set (ไม่บังคับ)

- เพิ่มโหนด "Set" เพื่อจัดรูปแบบการตอบสนอง

- กำหนดค่าเพื่อดึงการตอบสนองของ AI:

- เก็บเฉพาะชุด: เปิดใช้งาน

- ค่าที่จะตั้งค่า:

- ชื่อ:

ai_response - ค่า:

{{ $json.response }}

- ชื่อ:

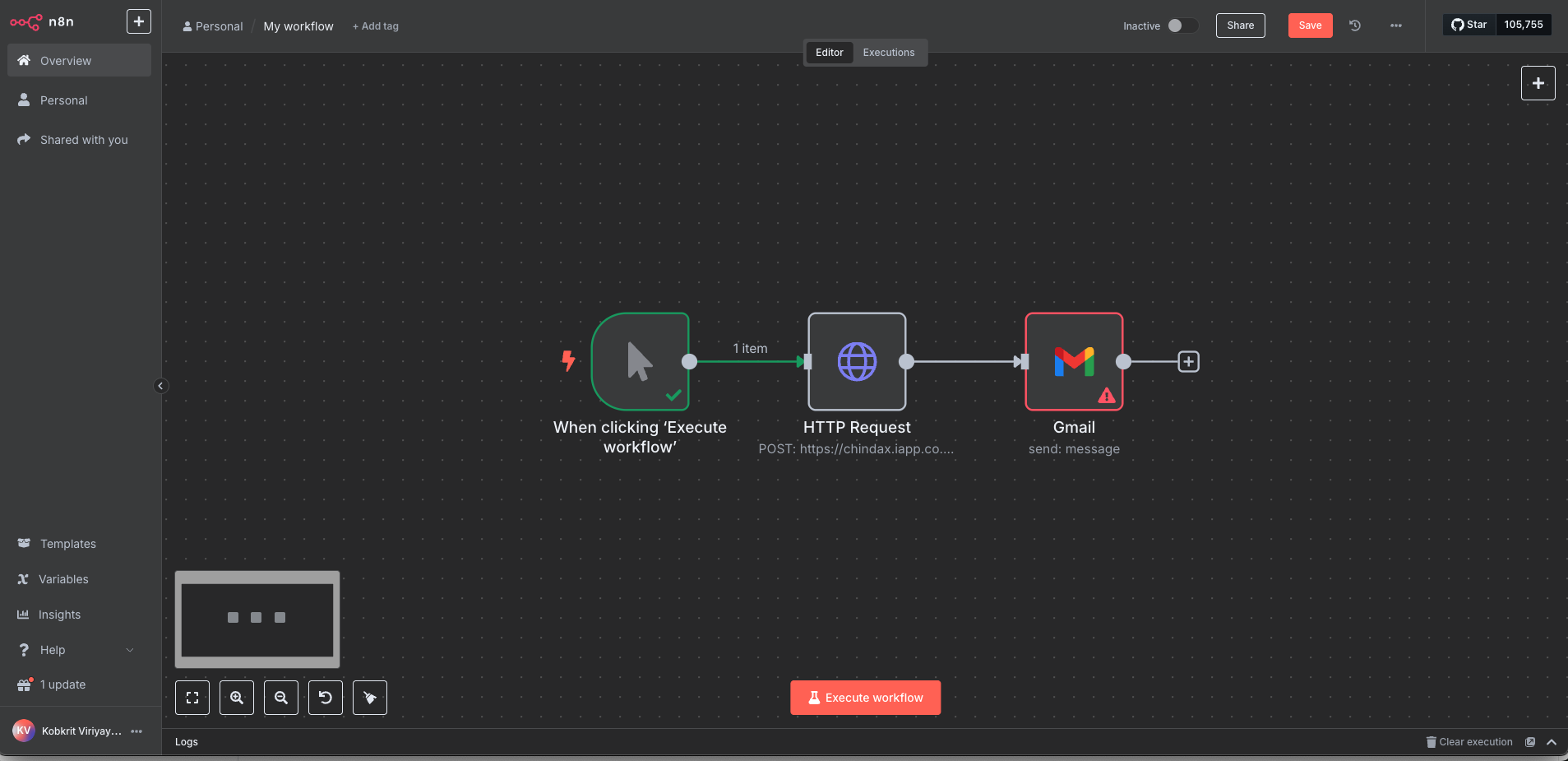

ตัวอย่างที่ 2: เวิร์กโฟลว์การประมวลผลอีเมล

เวิร์กโฟลว์นี้จะประมวลผลอีเมลภาษาไทยโดยอัตโนมัติและสร้างการตอบสนอง

โครงสร้างเวิร์กโฟลว์:

ตัวกระตุ้นอีเมล → สกัดเนื้อหาอีเมล → การประมวลผล Chinda LLM → ส่งการตอบสนอง

ขั้นตอนที่ 1: เพิ่มตัวกระตุ้นอีเมล

- เพิ่มโหนด "ตัวกระตุ้นอีเมล (IMAP)"

- กำหนดค่าการตั้งค่าอีเมลของคุณ:

- โฮสต์: เซิร์ฟเวอร์ IMAP ของผู้ให้บริการอีเมลของคุณ

- พอร์ต: โดยปกติ 993 สำหรับ SSL

- ชื่อผู้ใช้: ที่อยู่อีเมลของคุณ

- รหัสผ่าน: รหัสผ่านอีเมลของคุณ

- SSL/TLS: เปิดใช้งาน

ขั้นตอนที่ 2: ประมวลผลด้วย Chinda LLM

- เพิ่มโหนด "HTTP Request"

- กำหนดค่าสำหรับ Chinda LLM:

{

"model": "iapp/chinda-qwen3-4b",

"prompt": "ช่วยตอบอีเมลนี้อย่างสุภาพและเป็นมิตร: {{ $json.text }}",

"stream": false

}

ขั้นตอนที่ 3: ส่งอีเมลตอบกลับ

- เพิ่มโหนด "ส่งอีเมล"

- กำหนดค่าการตั้งค่าการตอบสนอง:

- ถึง:

{{ $json.from.value[0].address }} - หัวเรื่อง:

Re: {{ $json.subject }} - ข้อความ:

{{ $json.response }}

- ถึง:

🌐 ขั้นตอนที่ 4: เวิร์กโฟลว์ขั้นสูง

เวิร์กโฟลว์ที่ 1: บริการแปลเอกสาร

ส่วนประกอบ:

- ตัวกระตุ้น Webhook: รับเอกสารผ่าน HTTP

- สกัดข้อความ: ประมวลผลรูปแบบไฟล์ต่างๆ

- Chinda LLM: แปล ไทย ↔ อังกฤษ

- ส่งคืนการตอบสนอง: ส่งเนื้อหาที่แปลแล้ว

การตั้งค่า:

-

เพิ่มโหนด Webhook:

- ตั้งค่าพาธ webhook:

/translate - วิธีการ: POST

- ตั้งค่าพาธ webhook:

-

เพิ่มโหนด Switch (สำหรับการตรวจสอบประเภทไฟล์):

- เงื่อนไขที่ 1: ไฟล์ PDF

- เงื่อนไขที่ 2: ไฟล์ข้อความ

- เงื่อนไขที่ 3: เอกสาร Word

-

เพิ่ม HTTP Request สำหรับ Chinda LLM:

{

"model": "iapp/chinda-qwen3-4b",

"prompt": "ก�รุณาแปลข้อความนี้จากภาษาไทยเป็นภาษาอังกฤษ: {{ $json.text }}",

"stream": false

}

เวิร์กโฟลว์ที่ 2: แชทบอทฝ่ายสนับสนุนลูกค้า

ส่วนประกอบ:

- ตัวกระตุ้นแชท: เชื่อมต่อกับแพลตฟอร์มการส่งข้อความ

- การจัดการบริบท: รักษาประวัติการสนทนา

- Chinda LLM: สร้างการตอบสนอง

- การจัดรูปแบบการตอบสนอง: จัดรูปแบบสำหรับแพลตฟอร์มต่างๆ

การตั้งค่า:

-

เพิ่มตัวกระตุ้น Telegram (หรือแพลตฟอร์มที่คุณต้องการ)

-

เพิ่มโหนด Function สำหรับการจัดการบริบท:

// เก็บบริบทการสนทนา

const userId = $input.first().json.message.from.id;

const message = $input.first().json.message.text;

// ดึงบริบทก่อนหน้า (ใช้ตรรกะการจัดเก็บของคุณ)

const context = await getContext(userId);

return {

userId,

message,

context: context || [],

fullPrompt: `บริบทการสนทนา: ${context.join('\n')}\nคำถามใหม่: ${message}\nตอบ:`

}; -

เพิ่มการประมวลผล Chinda LLM

-

เพิ่มโหนดการตอบสนอง กลับไปยังแพลตฟอร์มแชท

เวิร์กโฟลว์ที่ 3: ท่อส่งข้อมูลการสร้างเนื้อหา

สำหรับบทความและรายการบล็อก:

- ตัวกระตุ้นกำหนดการ: เรียกใช้รายวัน/รายสัปดาห์

- ตัวอ่านฟีด RSS: รับแนวคิดหัวข้อ

- Chinda LLM: สร้างเนื้อหาภาษาไทย

- การจัดรูปแบบเนื้อหา: เพิ่ม HTML/Markdown

- การเผยแพร่ CMS: เผยแพร่โดยอัตโนมัติไปยัง WordPress/Ghost

💬 ขั้นตอนที่ 5: การใช้โหนด Chinda LLM (การผสานรวมแบบกำหนดเอง)

การสร้างโหนด Chinda LLM แบบกำหนดเอง

หากคุณใช้ Chinda LLM บ่อยๆ ให้สร้างโหนดแบบกำหนดเองที่สามารถนำกลับมาใช้ใหม่ได้:

ขั้นตอนที่ 1: สร้างเทมเพลตโหนด

{

"name": "Chinda LLM",

"icon": "🤖",

"group": ["AI"],

"description": "ประมวลผลข้อความด้วย Chinda LLM 4B",

"properties": [

{

"displayName": "คำถาม",

"name": "prompt",

"type": "string",

"required": true,

"default": "",

"description": "คำถามข้อความเป็นภาษาไทย"

},

{

"displayName": "อุณหภูมิ",

"name": "temperature",

"type": "number",

"default": 0.7,

"description": "ควบคุมความไม่แน่นอน (0-1)"

}

]

}

การใช้โหนด Code สำหรับการประมวลผลขั้นสูง

เพิ่มโหนด "Code" สำหรับการประมวลผลข้อความภาษาไทยที่ซับซ้อน:

// ประมวลผลข้อความภาษาไทยด้วย Chinda LLM

const axios = require('axios');

const prompt = $input.first().json.text;

const response = await axios.post('http://localhost:11434/api/generate', {

model: 'iapp/chinda-qwen3-4b',

prompt: `ประมวลผลข้อความนี้: ${prompt}`,

stream: false,

options: {

temperature: 0.7,

top_p: 0.9

}

});

return {

original: prompt,

processed: response.data.response,

timestamp: new Date().toISOString()

};

🔧 การแก้ไขปัญหา

ปัญหาและวิธีแก้ไขทั่วไป

ปัญหา: การเชื่อมต่อถูกปฏิเสธไปยัง Ollama

Error: connect ECONNREFUSED 127.0.0.1:11434

วิธีแก้ไข: ตรวจสอบให้แน่ใจว่า Ollama กำลังทำงานอยู่:

ollama serve

ปัญหา: เวิร์กโฟลว์ n8n หมดเวลา

วิธีแก้ไข: เพิ่มเวลาหมดเวลาในโหนด HTTP Request:

- ตั้งค่า เวลาหมดเวลา: 30000 (30 วินาที)

- สำหรับการตอบสนองที่ยาวนานขึ้น ให้เพิ่มขึ้นอีก

ปัญหา: ปัญหาหน่วยความจำกับคำถามขนาดใหญ่

วิธีแก้ไข:

- แบ่งข้อความขนาดใหญ่เป็นส่วนย่อยๆ

- ใช้การแบ่งหน้าในเวิร์กโฟลว์

- ใช้การสรุปข้อความก่อน

ปัญหา: ปัญหาการเข้ารหัสข้อความภาษาไทย

วิธีแก้ไข: ตรวจสอบให้แน่ใจว่าใช้การเข้ารหัส UTF-8 อย่างถูกต้อง:

// ในโหนด Code

const text = Buffer.from(inputText, 'utf8').toString('utf8');

เคล็ดลับการเพิ่มประสิทธิภาพ

- ใช้การประมวลผลแบบกลุ่ม สำหรับคำขอหลายรายการ

- ใช้การแคช สำหรับคำถามที่ใช้บ่อย

- ตั้งค่าเวลาหมดเวลาที่เหมาะสม ตามความซับซ้อนของคำถาม

- ตรวจสอบการใช้ทรัพยากร ของกระบวนการ Ollama

🎯 เทมเพลตเวิร์กโฟลว์และกรณีการใช้งาน

✅ เทมเพลตเวิร์กโฟลว์ที่พร้อมใช้งาน

1. บริการสรุปเอกสาร

- อินพุต: เอกสารภาษาไทยยาวๆ

- กระบวนการ: แบ่งเป็นส่วนย่อย → สรุปแต่ละส่วน → รวมกัน

- เอาต์พุต: สรุปภาษาไทยที่กระชับ

2. ตัวตอบสนองอัตโนมัติในโซเชียลมีเดีย

- ตัวกระตุ้น: การกล่าวถึง/ความคิดเห็นใหม่ๆ

- กระบวนการ: วิเคราะห์ความรู้สึก → สร้างการตอบสนองที่เหมาะสม

- การกระทำ: โพสต์การตอบสนองโดยอัตโนมัติ

3. ตัวสร้างจดหมายข่าวทางอีเมล

- กำหนดการ: ตัวกระตุ้นรายสัปดาห์

- กระบวนการ: รวบรวมข่าว → สร้างเนื้อหาภาษาไทย → จัดรูปแบบ

- การกระทำ: ส่งไปยังรายชื่อผู้สมัครรับข้อมูล

4. ตัววิเคราะห์ความคิดเห็นของลูกค้า

- อินพุต: ความคิดเห็น/ข้อเสนอแนะของลูกค้า

- กระบวนการ: การวิเคราะห์ความรู้สึก → การจัดประเภท → การตอบสนอง

- เอาต์พุต: แดชบอร์ดข้อมูลเชิงลึก

5. ผู้ช่วยการเรียนรู้ภาษา

- อินพุต: ข้อความภาษาอังกฤษจากนักเรียน

- กระบวนการ: แปล → อธิบายไวยากรณ์ → ให้ตัวอย่าง

- เอาต์พุต: สื่อการเรียนรู้ที่ครอบคลุม

🔄 ตัวอย่างการผสานรวม

ผสานรวมกับบริการยอดนิยม:

Google Sheets:

- อ่านข้อมูล → ประมวลผลด้วย Chinda LLM → เขียนผลลัพธ์

Slack/Discord:

- ตรวจสอบช่อง → ตอบคำถาม → ให้สรุป

WordPress:

- สร้างเนื้อหา → เผยแพร่โดยอัตโนมัติ → การเพิ่มประสิทธิภาพ SEO

Shopify:

- คำอธิบายผลิตภัณฑ์ → การสนับสนุนลูกค้า → การประมวลผลคำสั่งซื้อ

🚀 การกำหนดค่าขั้นสูง

การตั้งค่าตัวแปรสภาพแวดล้อม

สร้างไฟล์ .env สำหรับ n8n:

# การกำหนดค่า n8n

N8N_BASIC_AUTH_ACTIVE=true

N8N_BASIC_AUTH_USER=admin

N8N_BASIC_AUTH_PASSWORD=yourpassword

# การกำหนดค่า Ollama

OLLAMA_HOST=http://localhost:11434

CHINDA_MODEL=iapp/chinda-qwen3-4b

# การกำหนดค่า Webhook

WEBHOOK_URL=http://localhost:5678/webhook

การตั้งค่า Docker Compose

version: '3.8'

services:

n8n:

image: n8nio/n8n

ports:

- "5678:5678"

environment:

- N8N_BASIC_AUTH_ACTIVE=true

- N8N_BASIC_AUTH_USER=admin

- N8N_BASIC_AUTH_PASSWORD=yourpassword

volumes:

- ~/.n8n:/home/node/.n8n

depends_on:

- ollama

ollama:

image: ollama/ollama

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

command: serve

volumes:

ollama:

เรียกใช้ด้วย:

docker-compose up -d

📊 การตรวจสอบและการวิเคราะห์

การติดตามประสิทธิภาพเวิร์กโฟลว์

เพิ่มโหนดการตรวจสอบเพื่อติดตาม:

- เวลาตอบสนอง จาก Chinda LLM

- อัตราความสำเร็จ/ความล้มเหลว ของเ�วิร์กโฟลว์

- สถิติการใช้งาน ต่อเวิร์กโฟลว์

- การติดตามต้นทุน (หากใช้ API ที่เสียค่าใช้จ่าย)

ตัวอย่างเวิร์กโฟลว์การตรวจสอบ:

การดำเนินการเวิร์กโฟลว์ → บันทึกประสิทธิภาพ → อัปเดตแดชบอร์ด → ส่งการแจ้งเตือน

🔮 แนวทางปฏิบัติที่ดีที่สุด

1. การออกแบบคำถามสำหรับภาษาไทย

- ใช้คำถามภาษาไทยที่ชัดเจนและมีความหมาย

- ให้ตัวอย่างเมื่อจำเป็น

- ระบุข้อกำหนดรูปแบบเอาต์พุต

2. การจัดการข้อผิดพลาด

- เพิ่มโหนดการจัดการข้อผิดพลาดเสมอ

- ใช้กลไกกา�รลองใหม่

- บันทึกข้อผิดพลาดสำหรับการแก้จุดบกพร่อง

3. ข้อควรพิจารณาเกี่ยวกับความปลอดภัย

- ใช้ตัวแปรสภาพแวดล้อมสำหรับข้อมูลที่ละเอียดอ่อน

- ใช้การตรวจสอบสิทธิ์อย่างถูกต้อง

- ตรวจสอบอินพุตก่อนการประมวลผล

4. ความสามารถในการปรับขนาด

- ออกแบบเวิร์กโฟลว์เพื่อจัดการกับภาระงานที่แตกต่างกัน

- ใช้คิวสำหรับการประมวลผลปริมาณมาก

- ตรวจสอบการใช้ทรัพยากร

📚 แหล่งข้อมูลและลิงก์

คำสั่งอ้างอิงด่วน

# เริ่มต้น n8n

npm start n8n

# หรือ

npx n8n

# หรือ

docker run -p 5678:5678 n8nio/n8n

# เริ่มต้น Ollama

ollama serve

# ดาวน์โหลด Chinda LLM

ollama pull iapp/chinda-qwen3-4b

ลิงก์ที่เป็นประโยชน์

- 🌐 เอกสาร n8n: https://docs.n8n.io/

- 🤖 Chinda LLM Demo: https://chindax.iapp.co.th

- 📦 Ollama: https://ollama.com/iapp/chinda-qwen3-4b

- 🏠 หน้าหลัก iApp: https://iapp.co.th/products/chinda-opensource-llm

- 📄 ใบอนุญาต: Apache 2.0 (อนุญาตให้ใช้ในเชิงพาณิชย์และส่วนบุคคล)

ชุมชนและการสนับสนุน

- ชุมชน n8n: https://community.n8n.io/

- การสนับสนุน iApp: https://iapp.co.th/contact

- ปัญหา GitHub: https://github.com/n8n-io/n8n/issues

🎉 สรุป

การรวม Chinda LLM 4B กับ n8n สร้างเวิร์กโฟลว์การทำงานอัตโนมัติที่ทรงพลัง ซึ่งสามารถประมวลผลเนื้อหาภาษาไทยได้ในระดับใหญ่ ไม่ว่าคุณจะสร้างระบบสนับสนุนลูกค้า ท่อส่งข้อมูล�การสร้างเนื้อหา หรือเวิร์กโฟลว์การประมวลผลข้อมูล การผสมผสานนี้จะมอบ:

- การสร้างเวิร์กโฟลว์แบบภาพที่ง่ายดาย - ไม่ต้องเขียนโค้ด

- การประมวลผลภาษาไทยที่ทรงพลัง - ความสามารถของ AI ภาษาไทยพื้นเมือง

- การผสานรวมที่ยืดหยุ่น - เชื่อมต่อกับบริการหลายร้อยรายการ

- สถาปัตยกรรมที่ปรับขนาดได้ - จัดการเวิร์กโฟลว์ตั้งแต่แบบง่ายไปจนถึงแบบซับซ้อน

- คุ้มค่า - เรียกใช้ในเครื่องท้องถิ่นโดยไม่มีค่าใช้จ่าย API

เริ่มสร้างเวิร์กโฟลว์การทำงานอัตโนมัติ AI ภาษาไทยของคุณวันนี้ด้วย n8n และ Chinda LLM 4B!

สร้างด้วย ❤️ โดยทีมงาน ไอแอพพ์เทคโนโลยี - เสริมพลังการทำงานอัตโนมัติด้วย AI ภาษาไทย